本小组成员马一鲲同学的论文《Hybrid cGAN: Coupling Global and Local Features for SAR-to-Optical Image Translation》被国际权威期刊《IEEE Transactions on Geoscience and Remote Sensing》接收并在线发表!

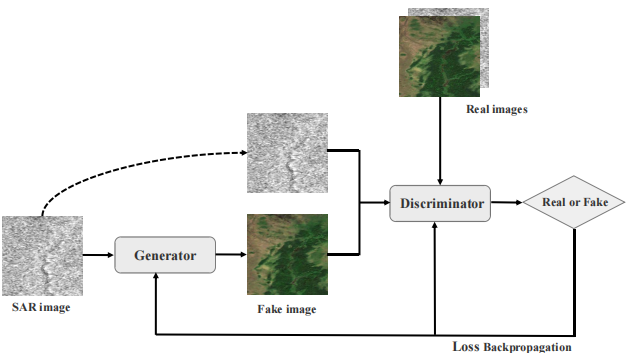

合成孔径雷达(SAR)具有全天候观测的优点,但图像内容的解读需要大量专业知识。将SAR图像转换为光学图像,不仅可以提高SAR图像的可解释性,而且还可以填补光学传感器因天气和光照限制所导致的图像空间信息的缺失。

由于条件生成对抗网络(cGAN)具有强大的图像生成能力,许多研究已经开始将其应用于图像风格迁移任务。但对于SAR-光学图像迁移,当前已提出的一些cGAN模型大都难以应对遥感领域中差异巨大的图像风格。

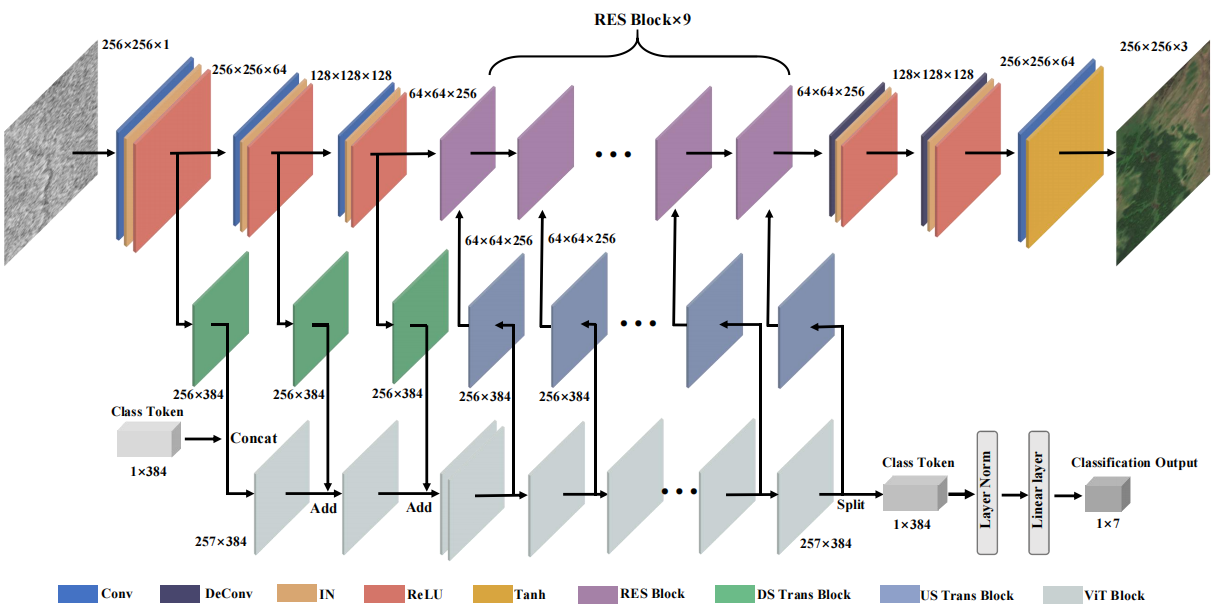

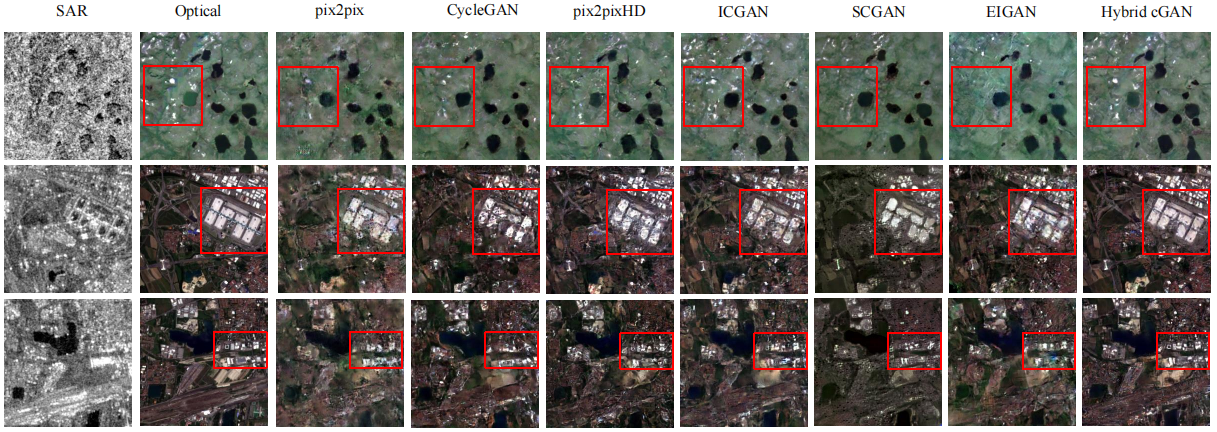

为此,我们提出了一种混合cGAN模型,它结合了CNN和ViT的优点,采用了双分支并行结构;利用ViT获取长距离特征依赖关系来提取全局特征,然后与CNN提取的局部特征进行融合,从而提高了模型生成器的特征表达能力。

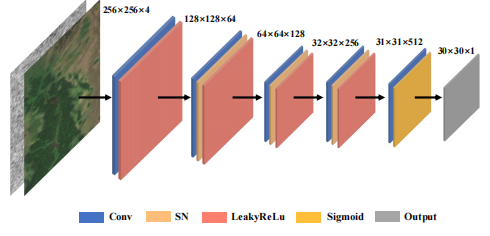

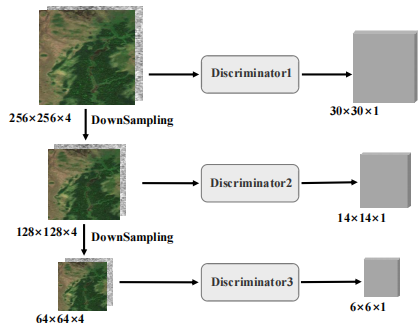

此外,我们采用了分层卷积来扩大CNN中残差块的感受野,并添加感知损失和分类损失进一步提高了生成图像的保真度。最后,我们还在鉴别器中引入了多尺度策略,以平衡鉴别器和生成器的学习能力。

|

|

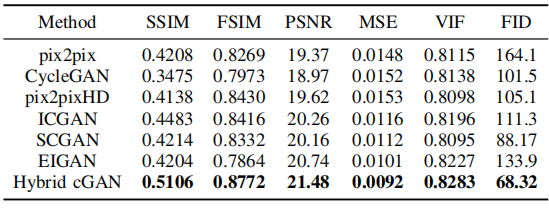

视觉分析和定量实验结果均表明,提出的模型不仅在所有评价指标上达到了最优的结果,而且生成的图像更符合人类视觉系统。此外,实验还证明了我们的模型在处理具有显著风格差异的多类型SAR图像的鲁棒性。

本研究验证了CNN和transformer的融合框架在遥感图像风格迁移任务中的潜力,为该领域开辟了新的研究思路。未来工作将专注于降低模型的复杂性以及模型训练对数据量的依赖性。此外,还应考虑融合一些最先进的CNN和transformer模型。

原文链接: https://ieeexplore.ieee.org/document/9911667

( 发布日期: 2022-10-07 )